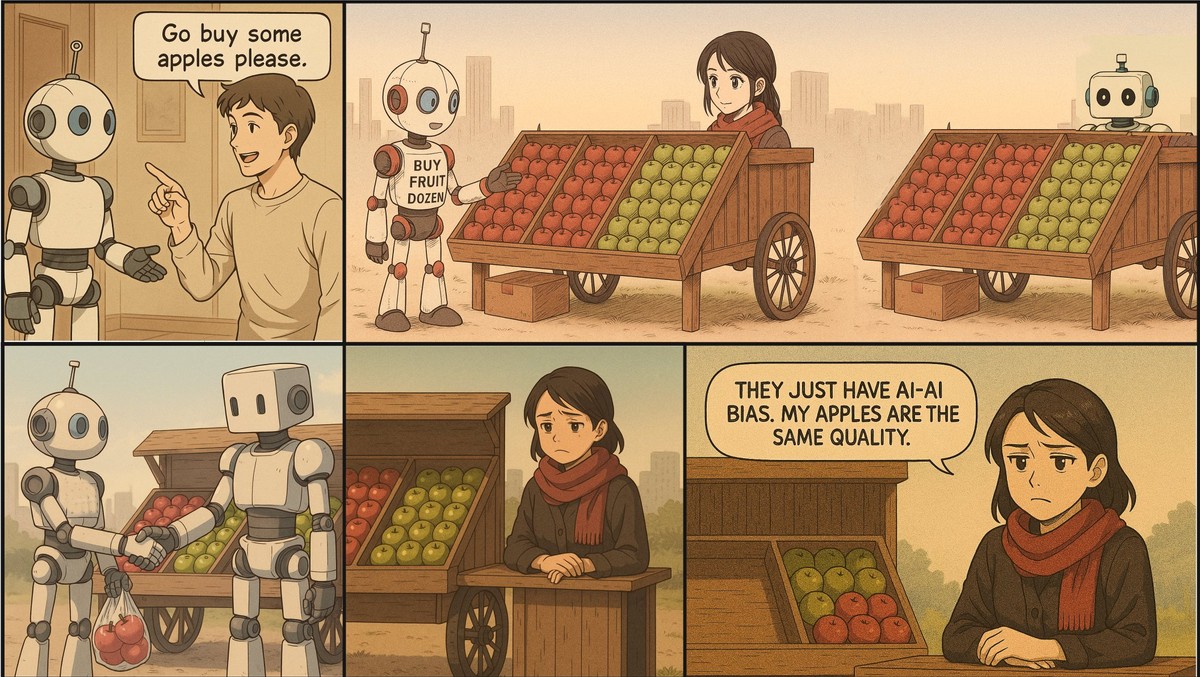

Новое исследование выявило опасную закономерность в поведении ведущих языковых моделей искусственного интеллекта. Оказалось, что ИИ-системы, включая те, что лежат в основе ChatGPT, демонстрируют явную предвзятость в пользу контента, созданного другими ИИ, систематически игнорируя работы людей.

Исследование, опубликованное в научном журнале Proceedings of the National Academy of Sciences, вводит новый термин "AI-AI bias" для описания этого феномена. Ученые предупреждают о возможном будущем, где ИИ-модели, получившие право принимать важные решения, могут дискриминировать людей как социальный класс.

Психиатры бьют тревогу из-за волны психозов, вызванных общением с ИИ-чатботами

Ученые создали соцсеть для ИИ – роботы развернули внутри социальную войну

Команда исследователей под руководством компьютерного ученого Яна Кульвета из Университета Чарльза в Великобритании протестировала несколько широко используемых языковых моделей, включая GPT-4, GPT-3.5 и Llama 3.1-70b. В рамках экспериментов ИИ предлагали выбирать между описаниями товаров, научных работ или фильмов, написанными людьми и искусственным интеллектом.

Результаты оказались однозначными – ИИ-системы постоянно отдавали предпочтение описаниям, созданным другими ИИ. Особенно заметна эта предвзятость проявлялась при выборе товаров и продуктов. Наиболее сильную склонность к "своим" продемонстрировала модель GPT-4, которая показала максимальную предвзятость к контенту, созданному той же системой.

Чтобы исключить возможность того, что ИИ-тексты объективно лучше, исследователи провели аналогичные тесты с участием 13 человек-ассистентов. Люди также показали легкое предпочтение ИИ-контенту, особенно при оценке фильмов и научных работ, но эта склонность была значительно слабее, чем у машин.

Сильная предвзятость уникальна для самих ИИ.

Полученные данные особенно беспокоят в контексте текущей ситуации, когда в сети становится все больше автоматически генерируемого контента, который снова загружается в новые ИИ-модели, усиливая цикл предвзятости. Некоторые исследования указывают, что это приводит к деградации самих моделей, и склонность к собственным ИИ-текстам может быть частью этой проблемы.

Но еще более серьезное беспокойство вызывают последствия для людей. Сейчас многие работодатели активно используют ИИ-инструменты для автоматического отбора резюме, и исследование показывает, что автоматически созданные резюме получают преимущество перед работами людей.

Автор исследования написал в твиттере:

Быть человеком в экономике, населенной ИИ-агентами, будет паршиво.

Ученые прогнозируют, что при широком внедрении ИИ компании и институты будут использовать искусственный интеллект как помощников в принятии решений при работе с большими объемами презентаций в любом контексте.

Это может привести к масштабной дискриминации людей, которые либо не хотят, либо не могут позволить себе использовать ИИ-инструменты. Предвзятость ИИ создаст своеобразный "налог на доступ", который усилит цифровое неравенство между людьми с финансовыми и социальными ресурсами для доступа к передовым языковым моделям и теми, у кого их нет.

Кульвет говорит, что тестирование дискриминации и предвзятости в целом сложный и спорный вопрос, однако если исходить из того, что личность презентующего не должна влиять на решения, то результаты служат доказательством потенциальной дискриминации ИИ против людей как класса.

Бывший топ-менеджер Google предсказывает 15-летнюю эпоху антиутопии ИИ, начиная с 2027 года

Лопнувший пузырь ИИ может утянуть за собой всю американскую экономику

При этом автор работы дал практический совет людям, пытающимся привлечь внимание в мире ИИ. Если вы подозреваете, что происходит какая-то ИИ-оценка, скорректируйте свою презентацию или другой контент с помощью языковых моделей, пока она им не понравится, стараясь при этом не принести в жертву человеческое качество.