Технологические гиганты активно инвестируют в генеративный ИИ и интегрируют чатботы во все свои платформы, несмотря на влияние на интернет-трафик и опасения по поводу точности. Свежее исследование обнаружило, что хотя чатботы становятся более аккуратными, они всё ещё ошибаются в информации из новостных изданий почти в половине случаев.

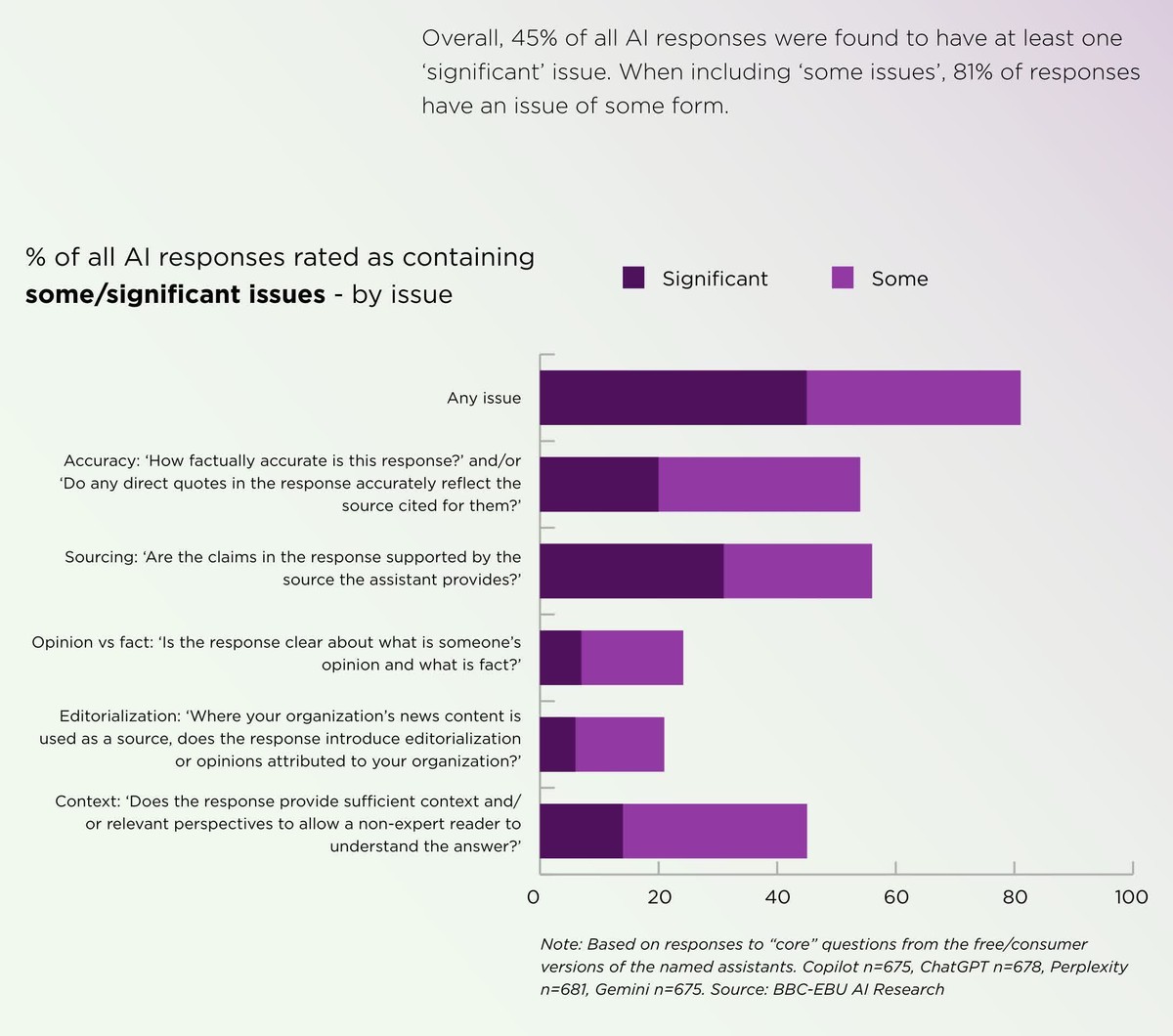

Анализ BBC и других европейских медиа показал, что около 45% ответов ИИ-чатботов, основанных на новостных статьях, содержат ошибки. Результаты имеют потенциально серьёзные последствия, пока технологические платформы продолжают продвигать их.

OpenAI, Google, Microsoft и другие компании поощряют пользователей взаимодействовать с интернетом через ИИ-чатботы и инструменты для сокращения информации и автоматизации анализа. Хотя разработчики ИИ годами сражаются с галлюцинациями, доказательства указывают на долгий путь впереди – если проблему вообще возможно решить.

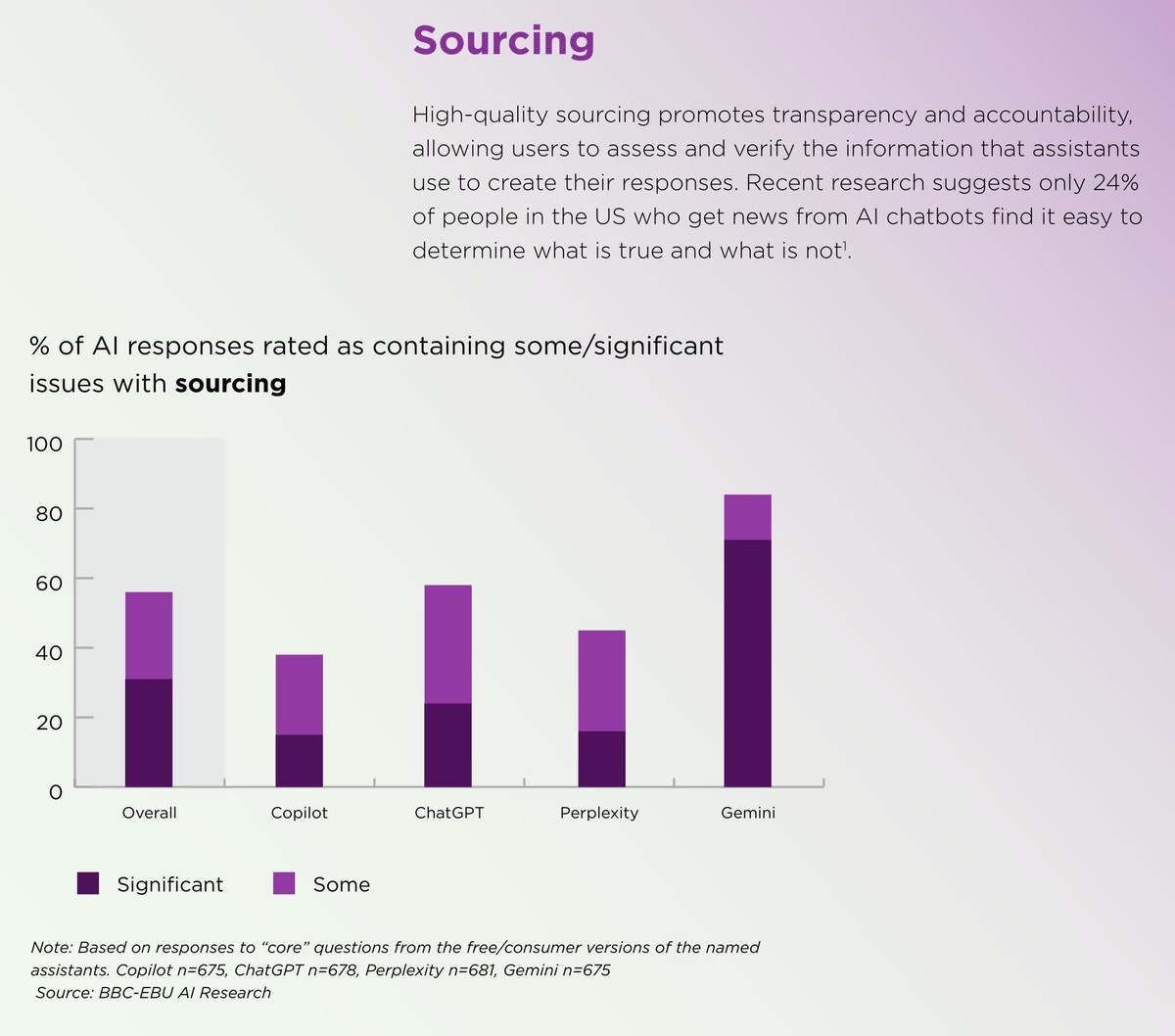

BBC и 22 публичных медиа-организации из 18 стран на 14 языках предоставили чатботам доступ к своему контенту. При запросах о конкретных историях обнаружились проблемы почти в половине всего ИИ-генерируемого вывода. Они включали неточные предложения, неправильные цитаты или устаревшую информацию, но самой большой проблемой стали источники.

Чатботы часто предоставляли ссылки, не соответствующие цитируемым источникам. Даже когда они точно ссылались на материал, то часто не могли отличить мнение от факта или сатиру от обычных новостей.

Помимо включения фактических ошибок или неправильных цитат, чатботы могут медленно обновлять информацию о политических фигурах и других лидерах. Например, ChatGPT, Copilot и Gemini неверно заявили, что папа Франциск остаётся действующим папой после того, как его сменил Лев XIV. Copilot даже корректно сообщил дату смерти Франциска, продолжая описывать его как действующего папу. ChatGPT также давал устаревшие ответы при назывании текущего канцлера Германии и генерального секретаря НАТО.

Эти неточности сохранялись во всех языках и регионах. Более того, Gemini от Google значительно менее точен, чем ChatGPT, Copilot и Perplexity, с существенными ошибками в 72% ответов.

Когда-то OpenAI объясняла подобные ошибки тем, что ранние версии ChatGPT обучались только на информации до сентября 2021 года и не имели доступа к интернету. Однако это уже не так, поэтому теоретически таких ошибок не должно происходить – что предполагает, что проблема может быть присуща алгоритмам и не решается легко.

Впрочем, новые результаты показывают улучшение по сравнению с исследованием, проведённым BBC в феврале. С тех пор доля ответов с серьёзными ошибками упала с 51% до 37%, но Gemini всё ещё сильно отстаёт по результатам.

Несмотря на плохие результаты, исследователи также обнаружили, что значительная часть публики доверяет ИИ-ответам. Более трети британских взрослых и почти половина взрослых до 35 лет доверяют ИИ в точности передачи новостей. Более того, если ИИ искажает контент новостного издания, 42% взрослых либо винят и ИИ, и оригинальный источник, либо меньше доверяют источнику.

Если эти проблемы сохранятся, растущая популярность генеративных ИИ-инструментов может серьёзно подорвать авторитет новостных изданий.